¿Cómo funciona la separación de audio por IA?

9 feb 2026

Los modelos de separación de audio por IA han cambiado fundamentalmente la forma en que tantos profesionales de los medios, creadores e investigadores entienden y manipulan el sonido, permitiendo aislar el habla, la música y el ruido de fondo de una sola grabación con una precisión notable. Para comprender verdaderamente el poder de esta tecnología, es importante aprender cómo funciona la separación de audio, qué ocurre entre bastidores y por qué los enfoques modernos impulsados por IA superan a los métodos tradicionales por un margen tan amplio.

En este artículo, exploraremos cómo funciona la separación de audio desde una perspectiva tanto conceptual como técnica, explicaremos la evolución de los modelos de separación de audio por IA y examinaremos cómo herramientas del mundo real como Fish Audio y SAM audio ponen en práctica estas ideas.

¿Qué es la separación de audio?

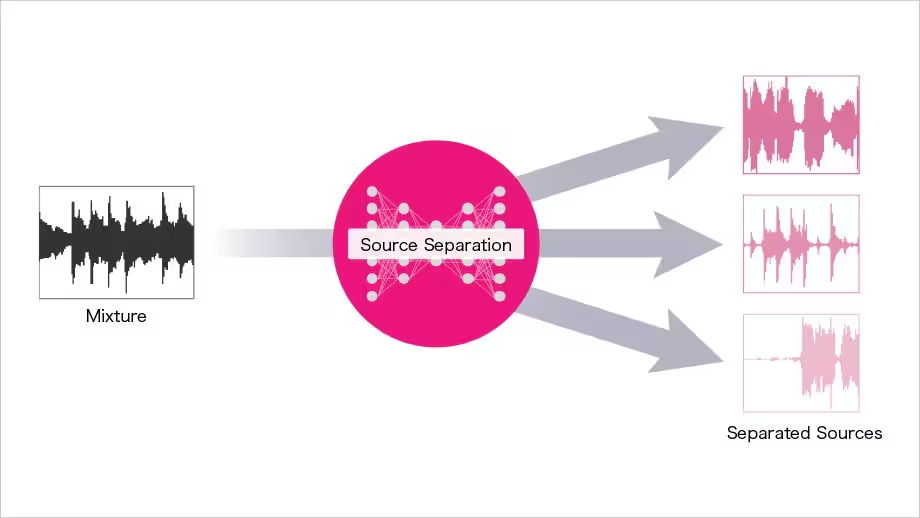

La separación de audio es el proceso de dividir una señal de audio mezclada en sus componentes individuales. Estos componentes pueden incluir habla, música, ruido ambiental, efectos de sonido o incluso locutores individuales. Comprender cómo funciona la separación de audio comienza por reconocer que la mayoría de las grabaciones son mezclas, no fuentes de sonido aisladas.

Históricamente, separar estos componentes requería edición manual, filtrado de frecuencia o costosas herramientas de estudio profesional. Hoy en día, los modelos de separación de audio por IA pueden analizar una sola forma de onda y predecir qué partes pertenecen a cada fuente de sonido, todo en segundos.

En esencia, el funcionamiento de la separación de audio depende de la identificación de patrones dentro del sonido: patrones que distinguen una voz humana del ruido del tráfico o un instrumento musical del ambiente de fondo.

¿Por qué es difícil la separación de audio?

Para entender por qué los modelos de separación de audio por IA son tan valiosos, primero hay que entender por qué el problema en sí es difícil. Las fuentes de sonido se superponen intensamente en tiempo y frecuencia. Dos personas hablando al mismo tiempo suelen ocupar rangos de frecuencia similares, lo que hace extremadamente difícil aislar una voz utilizando técnicas tradicionales.

Otras complicaciones incluyen:

-

Reverberación y eco

-

Grabaciones de baja calidad

-

Ruido de fondo dinámico

-

Artefactos de compresión

-

Superposición de habla y música

Los enfoques clásicos de procesamiento de señales tienen dificultades en estos casos, razón por la cual es tan importante aprender cómo funciona la separación de audio en un contexto de IA.

Métodos tradicionales de separación de audio

Antes de que los modelos de separación de audio por IA se generalizaran, los ingenieros confiaban en enfoques basados en reglas. Estos incluían:

Filtrado de frecuencia

Este método elimina o reduce ciertas bandas de frecuencia. Aunque es eficaz para la eliminación de ruido simple, falla cuando el habla y el ruido se superponen en frecuencia.

Cancelación de fase

Utilizada en grabaciones estéreo, la cancelación de fase puede aislar sonidos situados en ubicaciones espaciales específicas. Sin embargo, solo funciona en condiciones muy controladas.

Edición manual

Los ingenieros de audio suelen cortar, silenciar o atenuar manualmente partes de una forma de onda. Este proceso requiere mucho tiempo y no es práctico para flujos de trabajo a gran escala.

Estas limitaciones sentaron las bases para las soluciones modernas impulsadas por IA y empujaron a los investigadores a replantearse cómo funciona la separación de audio a un nivel fundamental.

El auge de los modelos de separación de audio por IA

Los modelos de separación de audio por IA utilizan el aprendizaje automático para aprender patrones a partir de conjuntos de datos masivos de audio mezclado y aislado. En lugar de seguir reglas fijas, estos modelos aprenden cómo se comportan estadísticamente las diferentes fuentes de sonido.

Al entrenarse con miles o incluso millones de ejemplos, los sistemas de IA aprenden:

-

Cómo suena típicamente el habla

-

Cómo difiere la música del diálogo

-

Cómo se comporta el ruido de fondo a lo largo del tiempo

-

Cómo interactúan los sonidos superpuestos

Este enfoque basado en el aprendizaje es la razón clave por la que los modelos de separación de audio por IA funcionan tan bien en una amplia gama de escenarios del mundo real.

Cómo funciona la separación de audio en el aprendizaje automático

Para entender cómo funciona la separación de audio en los sistemas de IA, resulta útil dividir el proceso en etapas.

1. Representación de audio

El audio bruto se convierte primero en una representación que el modelo pueda entender, comúnmente un espectrograma. Un espectrograma muestra cómo cambia el contenido de frecuencia a lo largo del tiempo, facilitando la detección de patrones.

Este paso es esencial porque los modelos de separación de audio por IA se basan en el reconocimiento de patrones de tipo visual aplicados al sonido.

2. Extracción de características

El modelo extrae características significativas del espectrograma, como estructuras armónicas, ritmos temporales y contornos de frecuencia. Estas características ayudan al sistema a distinguir entre habla, música y ruido.

Comprender cómo funciona la separación de audio en esta etapa explica por qué la IA puede superar a los filtros simples: no se trata solo de eliminar frecuencias, sino de reconocer identidades sonoras.

3. Estimación de fuente

El modelo predice qué partes del audio pertenecen a cada fuente. Esto puede implicar la estimación de máscaras que “mantienen” el habla mientras suprimen otros sonidos.

Los modelos modernos de separación de audio por IA suelen utilizar redes neuronales profundas, como redes neuronales convolucionales (CNN) o transformers, para realizar esta tarea.

4. Reconstrucción

Finalmente, los componentes separados se reconstruyen de nuevo en señales de audio en el dominio del tiempo. El resultado son múltiples pistas limpias derivadas de una única entrada mezclada.

Tipos de modelos de separación de audio por IA

Existen varias categorías de modelos de separación de audio por IA, cada una diseñada para casos de uso específicos.

Separación de habla frente a ruido

Estos modelos se centran en aislar el habla humana del ruido ambiental. Se utilizan comúnmente en la mejora de llamadas, transcripción y herramientas de accesibilidad.

Separación de fuentes musicales

Los modelos centrados en la música separan voces, batería, bajo e instrumentos. Aunque no se centran en el habla, demuestran cómo funciona la separación de audio en diferentes dominios.

Separación de locutores (Diarización)

Estos modelos aíslan a locutores individuales de una sola grabación. Esto es particularmente valioso en entrevistas, reuniones y podcasts.

Modelos universales

Algunos modelos modernos de separación de audio por IA pretenden manejar todas las tareas anteriores utilizando una única arquitectura, adaptándose dinámicamente a diferentes tipos de audio.

Datos de entrenamiento: El motor oculto

Una parte crucial pero a menudo ignorada de cómo funciona la separación de audio son los datos de entrenamiento. Los modelos de IA requieren conjuntos de datos masivos de audio mezclado emparejados con pistas de referencia limpias.

Estos conjuntos de datos permiten al modelo aprender distinciones sutiles, tales como:

-

Sonidos de respiración frente a siseo de fondo

-

Armónicos vocales frente a instrumentos musicales

-

Habla con eco frente a ruido ambiental

La calidad y diversidad de los datos de entrenamiento determinan en gran medida el rendimiento de los modelos de separación de audio por IA en condiciones del mundo real.

Herramientas del mundo real que utilizan separación de audio por IA

Muchas herramientas modernas ponen en práctica estos conceptos. Plataformas como Fish Audio y SAM audio aprovechan los modelos de separación de audio por IA para ofrecer soluciones fáciles de usar sin necesidad de conocimientos técnicos.

Fish Audio, por ejemplo, permite a los usuarios cargar un archivo y separar automáticamente el habla del ruido de fondo o de las voces superpuestas. Del mismo modo, SAM audio aplica modelos avanzados para gestionar escenarios de audio complejos, poniendo la separación de nivel profesional al alcance de los usuarios cotidianos.

Estas herramientas demuestran cómo funciona la separación de audio en la práctica, no como una teoría abstracta, sino como un flujo de trabajo de producción fiable.

Precisión frente a artefactos

Ninguna discusión sobre los modelos de separación de audio por IA está completa sin abordar los artefactos. Los artefactos son distorsiones no deseadas o sonidos residuales que quedan tras la separación.

Los artefactos comunes incluyen:

-

Tonos de voz metálicos o robóticos

-

Ruido de fondo residual

-

Fluctuaciones repentinas de volumen

Comprender cómo funciona la separación de audio ayuda a los usuarios a minimizar estos problemas mediante el uso de audio de origen limpio, el ajuste de los parámetros del modelo y la combinación de la separación por IA con la edición manual.

Consideraciones computacionales

Los modelos de separación de audio por IA pueden ser computacionalmente intensivos. Los modelos más grandes ofrecen una mayor precisión, pero requieren más potencia de procesamiento.

Las herramientas basadas en la nube delegan esta carga a servidores remotos, mientras que las herramientas locales requieren CPU o GPU potentes. Esta compensación explica por qué algunos usuarios prefieren plataformas en línea como Fish Audio, mientras que otros eligen soluciones de código abierto fuera de línea.

Cómo funciona la separación de audio para la transcripción

Una de las aplicaciones más impactantes de los modelos de separación de audio por IA es la transcripción. Un audio limpio conduce a una mayor precisión en la transcripción, especialmente en grabaciones con múltiples interlocutores o ruido de fondo.

Al separar primero el habla, los motores de transcripción reciben una señal más clara, lo que reduce los errores de palabras y la confusión de los interlocutores. Este flujo de trabajo destaca cómo funciona la separación de audio como un paso fundamental y no como una función independiente.

Limitaciones de los modelos de separación de audio por IA

A pesar de su potencia, los modelos de separación de audio por IA no son perfectos. Sus limitaciones incluyen:

-

Dificultad con habla extremadamente superpuesta

-

Menor rendimiento en tipos de sonido no vistos previamente

-

Dependencia de la diversidad de los datos de entrenamiento

Comprender cómo funciona la separación de audio de forma realista ayuda a establecer las expectativas adecuadas y fomenta los flujos de trabajo híbridos que combinan la IA con la supervisión humana.

El futuro de la separación de audio por IA

El futuro de los modelos de separación de audio por IA reside en la adaptabilidad y el aprendizaje multimodal. Los investigadores están explorando sistemas que combinan el audio con señales visuales, el contexto del texto y la identidad del locutor.

A medida que los modelos sean más eficientes, la separación en tiempo real se convertirá en un estándar en las herramientas de comunicación, las plataformas de videoconferencia y las emisiones en directo.

Los avances en el aprendizaje autosupervisado también pueden reducir la necesidad de conjuntos de datos etiquetados, mejorando aún más el funcionamiento de la separación de audio en distintos idiomas y entornos.

Mejores prácticas para el uso de herramientas de separación de audio

Para sacar el máximo partido a los modelos de separación de audio por IA, tenga en cuenta estas prácticas recomendadas:

-

Grabe el audio más limpio posible

-

Utilice la separación como un proceso por etapas

-

Combine la salida de la IA con el refinamiento manual

-

Conserve siempre las grabaciones originales

Estos pasos ayudan a garantizar que la teoría de cómo funciona la separación de audio se traduzca en resultados utilizables y de calidad profesional.

Conclusión

El procesamiento de sonido impulsado por IA ha llegado a un punto en el que tareas complejas, antes reservadas principalmente a especialistas, son ahora accesibles para todo el mundo; y comprender cómo funciona la separación de audio revela por qué este cambio es tan transformador. Desde las redes neuronales y el análisis de espectrogramas hasta herramientas del mundo real como Fish Audio y SAM audio, la tecnología que sustenta la separación de audio sigue evolucionando rápidamente. A medida que estos sistemas se vuelvan más precisos, eficientes y ampliamente disponibles, los modelos de separación de audio por IA seguirán siendo el núcleo de cómo limpiamos, analizamos y mejoramos el sonido en el mundo digital moderno.

James is a legendary machine learning engineer working across infrastructure and automation. Find him fiddling with 67 software and hardware systems at twango.dev since 2006.

Leer más de James Ding >