Comment fonctionne la séparation audio par IA

9 févr. 2026

Les modèles de séparation audio par IA ont fondamentalement changé la manière dont de nombreux professionnels des médias, créateurs et chercheurs appréhendent et manipulent le son, permettant d'isoler la parole, la musique et le bruit de fond d'un enregistrement unique avec une précision remarquable. Pour comprendre véritablement la puissance de cette technologie, il est important de découvrir comment fonctionne la séparation audio, ce qui se passe en coulisses et pourquoi les approches modernes basées sur l'IA surpassent les méthodes traditionnelles d'une marge aussi importante.

Dans cet article, nous explorerons le fonctionnement de la séparation audio d'un point de vue conceptuel et technique, expliquerons l'évolution des modèles de séparation audio par IA et examinerons comment des outils concrets comme Fish Audio et SAM audio mettent ces idées en pratique.

Qu'est-ce que la séparation audio ?

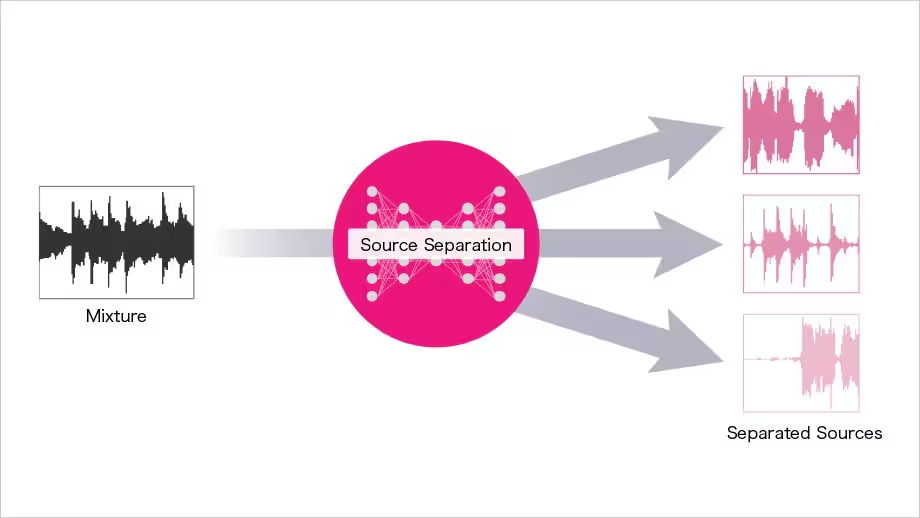

La séparation audio est le processus consistant à décomposer un signal audio mixte en ses composants individuels. Ces composants peuvent inclure la parole, la musique, le bruit ambiant, les effets sonores ou même des locuteurs individuels. Comprendre comment fonctionne la séparation audio commence par reconnaître que la plupart des enregistrements sont des mélanges et non des sources sonores isolées.

Historiquement, la séparation de ces composants nécessitait un montage manuel, un filtrage de fréquence ou des outils de studio coûteux. Aujourd'hui, les modèles de séparation audio par IA peuvent analyser une forme d'onde unique et prédire quelles parties appartiennent à quelle source sonore, le tout en quelques secondes.

À la base, le fonctionnement de la séparation audio dépend de l'identification de motifs au sein du son — des motifs qui distinguent une voix humaine du bruit de la circulation ou un instrument de musique de l'ambiance de fond.

Pourquoi la séparation audio est-elle difficile ?

Pour comprendre pourquoi les modèles de séparation audio par IA sont si précieux, vous devez d'abord comprendre pourquoi le problème lui-même est difficile. Les sources sonores se chevauchent fortement dans le temps et en fréquence. Deux personnes parlant en même temps occupent souvent des gammes de fréquences similaires, ce qui rend extrêmement difficile l'isolement d'une voix à l'aide de techniques traditionnelles.

D'autres complications incluent :

-

La réverbération et l'écho

-

Les enregistrements de mauvaise qualité

-

Le bruit de fond dynamique

-

Les artéfacts de compression

-

Le chevauchement de la parole et de la musique

Les approches classiques de traitement du signal peinent ici, c'est pourquoi il est si important d'apprendre comment la séparation audio fonctionne dans un contexte d'IA.

Méthodes de séparation audio traditionnelles

Avant que les modèles de séparation audio par IA ne se généralisent, les ingénieurs s'appuyaient sur des approches basées sur des règles. Celles-ci incluaient :

Filtrage de fréquence

Cette méthode supprime ou réduit certaines bandes de fréquences. Bien qu'efficace pour la suppression de bruit simple, elle échoue lorsque la parole et le bruit se chevauchent en fréquence.

Annulation de phase

Utilisée dans les enregistrements stéréo, l'annulation de phase peut isoler les sons positionnés à des emplacements spatiaux spécifiques. Cependant, elle ne fonctionne que dans des conditions très contrôlées.

Édition manuelle

Les ingénieurs du son coupent, coupent le son ou atténuent souvent manuellement des parties d'une forme d'onde. Ce processus est chronophage et peu pratique pour les flux de travail à grande échelle.

Ces limitations ont jeté les bases des solutions modernes pilotées par l'IA et ont poussé les chercheurs à repenser le fonctionnement de la séparation audio à un niveau fondamental.

L'essor des modèles de séparation audio par IA

Les modèles de séparation audio par IA utilisent l'apprentissage automatique pour apprendre des motifs à partir de vastes ensembles de données d'audio mixtes et isolés. Au lieu de suivre des règles fixes, ces modèles apprennent comment différentes sources sonores se comportent statistiquement.

En s'entraînant sur des milliers, voire des millions d'exemples, les systèmes d'IA apprennent :

-

À quoi ressemble typiquement la parole

-

Comment la musique diffère des dialogues

-

Comment le bruit de fond se comporte au fil du temps

-

Comment les sons qui se chevauchent interagissent

Cette approche basée sur l'apprentissage est la raison principale pour laquelle les modèles de séparation audio par IA sont si performants dans un large éventail de scénarios réels.

Comment fonctionne la séparation audio en Machine Learning

Pour comprendre comment fonctionne la séparation audio dans les systèmes d'IA, il est utile de décomposer le processus en étapes.

1. Représentation audio

L'audio brut est d'abord converti en une représentation que le modèle peut comprendre, généralement un spectrogramme. Un spectrogramme montre comment le contenu fréquentiel change au fil du temps, ce qui facilite la détection des motifs.

Cette étape est essentielle car les modèles de séparation audio par IA s'appuient sur une reconnaissance de motifs de type visuel appliquée au son.

2. Extraction de caractéristiques

Le modèle extrait des caractéristiques significatives du spectrogramme, telles que les structures harmoniques, les rythmes temporels et les contours de fréquence. Ces caractéristiques aident le système à distinguer la parole, la musique et le bruit.

Comprendre comment fonctionne la séparation audio à ce stade explique pourquoi l'IA peut surpasser les filtres simples : elle ne se contente pas de supprimer des fréquences, elle reconnaît les identités sonores.

3. Estimation de la source

Le modèle prédit quelles parties de l'audio appartiennent à chaque source. Cela peut impliquer l'estimation de masques qui « conservent » la parole tout en supprimant les autres sons.

Les modèles de séparation audio par IA modernes utilisent souvent des réseaux de neurones profonds tels que les réseaux de neurones convolutifs (CNN) ou les Transformers pour effectuer cette tâche.

4. Reconstruction

Enfin, les composants séparés sont reconstruits en signaux audio dans le domaine temporel. Le résultat est constitué de plusieurs pistes propres dérivées d'une seule entrée mixte.

Types de modèles de séparation audio par IA

Il existe plusieurs catégories de modèles de séparation audio par IA, chacune conçue pour des cas d'utilisation spécifiques.

Séparation Parole vs Bruit

Ces modèles se concentrent sur l'isolement de la parole humaine du bruit environnemental. Ils sont couramment utilisés dans l'amélioration des appels, la transcription et les outils d'accessibilité.

Séparation de sources musicales

Les modèles axés sur la musique séparent les voix, la batterie, la basse et les instruments. Bien qu'ils ne soient pas centrés sur la parole, ils démontrent comment la séparation audio fonctionne dans différents domaines.

Séparation de locuteurs (Diarisation)

Ces modèles isolent les locuteurs individuels d'un enregistrement unique. Ceci est particulièrement précieux pour les interviews, les réunions et les podcasts.

Modèles universels

Certains modèles modernes de séparation audio par IA visent à gérer toutes les tâches ci-dessus à l'aide d'une architecture unique, s'adaptant dynamiquement à différents types d'audio.

Données d'entraînement : Le moteur caché

Une partie cruciale mais souvent négligée du fonctionnement de la séparation audio est constituée par les données d'entraînement. Les modèles d'IA nécessitent des ensembles de données massifs d'audio mixte couplés à des pistes de référence propres.

Ces ensembles de données permettent au modèle d'apprendre des distinctions subtiles, telles que :

-

Les sons de respiration vs le sifflement de fond

-

Les harmoniques vocales vs les instruments de musique

-

La parole avec écho vs le bruit ambiant

La qualité et la diversité des données d'entraînement déterminent en grande partie l'efficacité des modèles de séparation audio par IA dans des conditions réelles.

Outils concrets utilisant la séparation audio par IA

De nombreux outils modernes mettent ces concepts en pratique. Des plateformes comme Fish Audio et SAM audio exploitent les modèles de séparation audio par IA pour fournir des solutions conviviales sans nécessiter d'expertise technique.

Fish Audio, par exemple, permet aux utilisateurs de télécharger un fichier et de séparer automatiquement la parole du bruit de fond ou des voix qui se chevauchent. SAM audio applique de la même manière des modèles avancés pour gérer des scénarios audio complexes, rendant la séparation de qualité professionnelle accessible aux utilisateurs quotidiens.

Ces outils démontrent comment la séparation audio fonctionne en pratique, non pas comme une théorie abstraite, mais comme un flux de travail de production fiable.

Précision vs Artéfacts

Aucune discussion sur les modèles de séparation audio par IA n'est complète sans aborder les artéfacts. Les artéfacts sont des distorsions indésirables ou des sons résiduels laissés après la séparation.

Les artéfacts courants incluent :

-

Des tons de parole métalliques ou robotiques

-

Du bruit de fond résiduel

-

Des fluctuations soudaines de volume

Comprendre comment fonctionne la séparation audio aide les utilisateurs à minimiser ces problèmes en utilisant un audio source propre, en ajustant les paramètres du modèle et en combinant la séparation par IA avec l'édition manuelle.

Considérations de calcul

Les modèles de séparation audio par IA peuvent être gourmands en ressources de calcul. Les modèles plus volumineux offrent une meilleure précision mais nécessitent plus de puissance de traitement.

Les outils basés sur le cloud déchargent ce fardeau sur des serveurs distants, tandis que les outils locaux nécessitent des processeurs (CPU) ou des cartes graphiques (GPU) puissants. Ce compromis explique pourquoi certains utilisateurs préfèrent les plateformes en ligne comme Fish Audio, tandis que d'autres choisissent des solutions open-source hors ligne.

Comment la séparation audio fonctionne pour la transcription

L'une des applications les plus percutantes des modèles de séparation audio par IA est la transcription. Un audio propre permet une plus grande précision de transcription, en particulier dans les enregistrements avec plusieurs locuteurs ou du bruit de fond.

En séparant d'abord la parole, les moteurs de transcription reçoivent un signal plus clair, réduisant les erreurs de mots et la confusion entre les locuteurs. Ce flux de travail souligne comment la séparation audio fonctionne comme une étape fondamentale plutôt que comme une fonctionnalité autonome.

Limites des modèles de séparation audio par IA

Malgré leur puissance, les modèles de séparation audio par IA ne sont pas parfaits. Les limitations incluent :

-

La difficulté avec la parole extrêmement chevauchée

-

Des performances réduites sur des types de sons non rencontrés lors de l'entraînement

-

La dépendance à la diversité des données d'entraînement

Comprendre de manière réaliste comment fonctionne la séparation audio aide à définir des attentes appropriées et encourage des flux de travail hybrides combinant l'IA et la supervision humaine.

L'avenir de la séparation audio par IA

L'avenir des modèles de séparation audio par IA réside dans l'adaptabilité et l'apprentissage multimodal. Les chercheurs explorent des systèmes qui combinent l'audio avec des indices visuels, le contexte textuel et l'identité du locuteur.

À mesure que les modèles deviennent plus efficaces, la séparation en temps réel deviendra la norme dans les outils de communication, les plateformes de visioconférence et la diffusion en direct.

Les progrès de l'apprentissage auto-supervisé pourraient également réduire le besoin d'ensembles de données étiquetés, améliorant encore le fonctionnement de la séparation audio à travers les langues et les environnements.

Bonnes pratiques pour l'utilisation des outils de séparation audio

Pour tirer le meilleur parti des modèles de séparation audio par IA, tenez compte de ces bonnes pratiques :

-

Enregistrez l'audio le plus propre possible

-

Utilisez la séparation comme un processus par étapes

-

Combinez la sortie de l'IA avec un affinement manuel

-

Gardez toujours les enregistrements originaux

Ces étapes permettent de s'assurer que la théorie du fonctionnement de la séparation audio se traduit par des résultats utilisables et de qualité professionnelle.

Conclusion

Le traitement sonore piloté par l'IA a atteint un point où des tâches complexes, autrefois réservées aux spécialistes, sont désormais accessibles à tous, et comprendre comment fonctionne la séparation audio révèle pourquoi ce changement est si transformateur. Des réseaux de neurones et de l'analyse de spectrogrammes aux outils concrets comme Fish Audio et SAM audio, la technologie derrière la séparation audio continue d'évoluer rapidement. À mesure que ces systèmes deviennent plus précis, efficaces et largement disponibles, les modèles de séparation audio par IA resteront au cœur de la manière dont nous nettoyons, analysons et améliorons le son dans le monde numérique moderne.

James is a legendary machine learning engineer working across infrastructure and automation. Find him fiddling with 67 software and hardware systems at twango.dev since 2006.

Lire plus de James Ding >